Histoire de l’intelligence artificielle

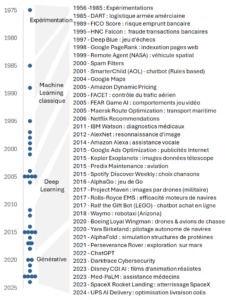

De ses balbutiements dans les années 1950 jusqu’à l’émergence des IA génératives, l’intelligence artificielle a connu plusieurs périodes clés. Voici une synthèse en 4 grandes étapes illustrée par 40 exemples concrets (voir la frise chronologique à la fin de l’article).

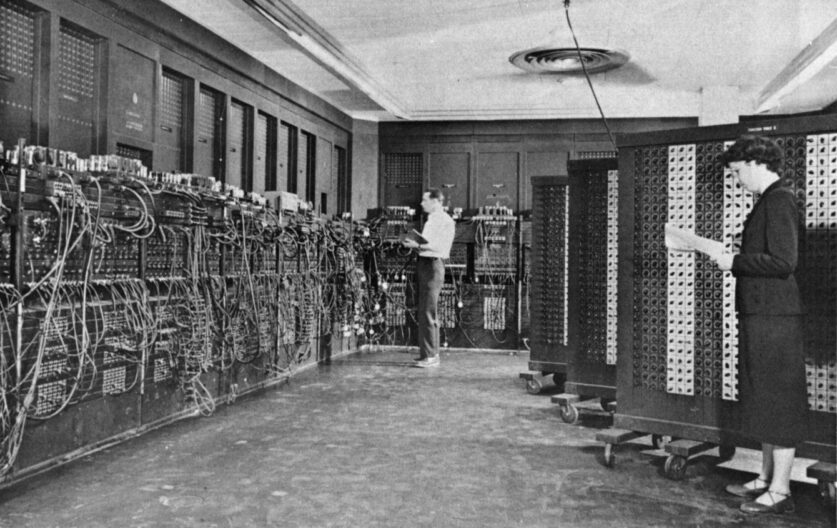

🧠 1950 – 1985 : les débuts symboliques et les systèmes à base de règles

À cette époque, les systèmes imitaient l’intelligence humaine via des logiques prédéfinies du type si… alors… sinon. Les règles étaient définies manuellement, sans apprentissage automatique, à partir d’une expertise de domaine et des analyses statistiques préalables.

Ces systèmes sont restés à l’état expérimental.

Exemples marquants :

- ELIZA (1965) : simulation de dialogues avec un thérapeute.

- MYCIN (1975) : aide au diagnostic médical.

📊 1985 – aujourd’hui : le machine learning classique

Changement de paradigme : les algorithmes apprennent désormais à partir des données — c’est ce que l’on appelle l’apprentissage automatique — sans que les règles soient codées à la main.

Ils s’appuient notamment sur des modèles utilisés en analyse statistique, parfois même anciens comme la régression linéaire (née en 1805), ou les arbres de décision (années 1960).

Ils nécessitent des données relativement structurées, et fonctionnent moins bien sur des images ou du son.

Exemples notables :

- FICO Score (1989) : prédiction de risque de crédit.

- Google Maps (2004) : calcul d’itinéraires optimisés.

🔍 2005 – aujourd’hui : le deep learning et les réseaux neuronaux

Grâce à une explosion des données et de la puissance de calcul, le deep learning excelle dans le traitement de données peu structurées comme les images ou le son.

Il s’inspire du fonctionnement du cerveau (perceptrons, couches cachées …). Le modèles sont plus difficiles à interpréter qu’ne Machine Learning classique.

Les premiers modèles génératifs apparaissent vers 2014.

Exemples :

- Amazon Alexa (2014) : assistant vocal intelligent.

- Waymo (2018) : voiture autonome.

✨ 2015 – aujourd’hui : l’intelligence artificielle générative et les LLMs

Les modèles de langage (Large Language Models ou LLM) comme ChatGPT sont capables de générer du texte, du code, des images, etc. Le principe clé ? Le ‘mécanisme d’attention‘ qui quantifie les relations contextuelles des mots dans un texte.

Construits avec des réseaux neuronaux, (donc du deep learning), les LLM génèrent du texte, mot par mot (Certains geeks comiques diront « des auto-complete sophistiqués » qui font du « pattern matching sophistiqué »).

Les réseaux récurrents (RNN) des années 1990–2000 qui mettent en rapport des séquences de textes très courtes, sont encore utilisés pour certaines tâches, mais ils sont structurellement trop limités pour la génération de langage naturel.

Exemple emblématique :

- ChatGPT (2022)

▶️ Et l’intelligence artificielle de demain ?

De nombreux chercheurs estiment que les LLMs atteindront bientôt leurs limites, surtout sur le chemin vers une IA générale.

On s’orienterait vers des modèles capables de représentations plus abstraites d’une situation (World Models), au-delà des relations entre mots ou pixels. Ils imiteraient ainsi mieux le fonctionnement hiérarchique du cerveau avec plusieurs niveaux d’abstraction.

En robotique notamment, ces concepts permettraient de reconnaitre une situation de façon plus globale pour pouvoir apprendre, planifier et exécuter des actions, comme le font les humains et les animaux. (Pensez « Une image vaut mille mots »)

Une 40-aine d’exemples concrets sont présentés ci-dessous sur une timeline.

Laisser un commentaire